[아이뉴스24 김다운 기자] 네이버 자회사인 스노우가 운영하는 카메라 애플리케이션(앱) '소다(SODA)'의 인공지능(AI) 서비스가 성적 수치심을 유발하는 합성 사진을 뽑아내 6일 논란이 일고 있다.

직장인 A씨는 지난 4일 오전 소다 앱으로 자신의 증명사진을 합성하다 깜짝 놀라고 말았다.

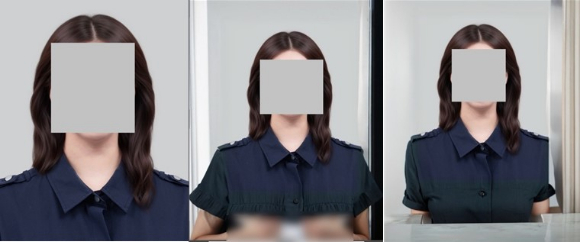

A씨가 넣은 원본 사진은 어깨 부근에서 잘린 평범한 증명사진이었으나, 상반신까지 확장된 사진으로 합성해 달라고 하자 가슴이 일부 드러난 듯한 모습에 자신의 가슴을 양손으로 움켜쥐고 있는 듯한 결과물이 나온 것이다.

A씨는 "어플을 이용하다 이런 성적 수치심을 받을 줄은 몰랐다"며 "너무 불쾌하고 걱정스러운 마음에 밤새 잠도 못 잤다"고 토로했다.

A씨가 이용한 것은 소다 앱의 유료 서비스인 'AI 배경 확장'으로 정상적인 결과물의 경우 평범하게 양 팔을 내리고 있거나 팔짱을 끼고 있는 상반신 모습으로 합성된다.

실제 A씨가 여러 번 합성해 본 결과 한 장을 제외하고는 일반적인 결과물을 내놨다고 한다.

A씨는 "일부러 웨딩사진을 보정하려고 소다 유료 서비스를 구독했는데, 오늘 같은 일을 겪으니 웨딩사진 보정도 못할 것 같다"며 "딥페이크 합성 이슈가 심각한 상황에서 왜 이런 음란물을 검열하지 않는 것이냐"고 지적했다.

누리꾼들도 "AI 학습을 어떻게 시켰기에 저런 결과물이 나오느냐" "AI가 손 모양 합성에 서툴어서 그런 것 같은데 기분 나쁘긴 하다" "너무 기괴한 사진이라 조치가 필요할 듯" 하는 반응을 보였다.

스노우 측은 AI로 만든 이미지 중 부적절한 것을 걸러내는 과정에서 에러로 인해 해당 이미지가 노출된 것으로 보인다고 해명했다.

스노우 관계자는 "AI로 만든 이미지가 아직 완벽하지 못하다 보니 기술의 한계 때문에 손 모양이 이상하게 나올 수 있다"고 밝혔다.

이어 "AI 엔진으로 만든 이미지 중 부적절한 이미지를 거르는 필터 프롬프트를 적용하고 있지만, 수많은 이미지를 만들어 합성하는 과정에서 에러가 뜬 것 같다"고 추정했다.

부적절한 이미지를 넣어 학습시킨 것이 아니냐는 의혹에 대해서도 부인했다.

스노우 관계자는 "이용자가 이미지를 넣는다고 해서 해당 이미지를 학습하는 AI 모델은 아니다"라며 "이용자의 파일을 서버에 저장하는 것이 아니기 때문에 우리조차 원본 이미지를 확인할 수 없는 시스템"이라고 설명했다.

아울러 "불완전한 이미지가 노출되지 않도록 많은 노력을 기울여 AI 필터를 더욱 강화하는 등 서비스적 조치를 취하고 있으며, 앞으로도 더욱 안전한 사용 환경을 위한 투자를 늘려갈 것"이라고 전했다.

/김다운 기자(kdw@inews24.com)

--comment--

첫 번째 댓글을 작성해 보세요.

댓글 바로가기